Actualmente desconocemos el razonamiento clínico objetivo de los residentes durante su formación, lo que impide orientar su reciclaje formativo a solventar los déficits detectados. El script concordance test (SCT) evalúa el razonamiento clínico planteando situaciones clínicas reales, pero aún no ha sido utilizado en España con contenidos propios de Atención Primaria. Por ello consideramos relevante diseñar un SCT de Atención Primaria que cumpla los criterios de validez, fiabilidad y aceptabilidad descritos en la bibliografía.

MétodosElaboración, corrección y validación de un SCT para evaluar el razonamiento clínico en Atención Primaria de los residentes y que incluya variables sociolaborales para estudiar su posible relación con la puntuación obtenida.

ResultadosNuestro cuestionario fue aprobado por un comité de expertos, alcanzó una fiabilidad y accesibilidad adecuadas, y distinguió a los expertos de los residentes. No se observaron diferencias estadísticamente significativas en función de la edad, género, tipo y duración de la formación recibida en Atención Primaria, y la realización de un curso sobre dicha formación.

ConclusionesSe construyó un SCT que obtuvo la aprobación por parte de un comité de expertos, cumplió con los criterios de fiabilidad y accesibilidad, y permitió objetivar diferencias significativas en el razonamiento clínico de los expertos y residentes. Excepto en el 2.o año de residencia, no se observaron diferencias estadísticamente significativas respecto al año formativo dentro de la residencia, la edad, el género, la realización y duración de la rotación en Atención Primaria y la realización de un curso sobre dicha formación.

Actual unawareness about paediatric resident's residency program factual clinical reasoning precludes professional retraining directed to solve deficiencies. Script concordance test (SCT) evaluates clinical reasoning due to its orientation to usual clinical practice but surprisingly it has not been used in Spain for Paediatric Primary Care clinical reasoning evaluation so far. Due to this we consider to be of relevance to design a paediatric primary care SCT which meets validity, reliability and accessibility criteria described in bibliography.

MethodsDevelopment, validation and application of an SCT questionnaire for clinical reasoning analysis in paediatric primary care applied on a population of paediatric residents and which includes demographic and employment data in order to study possible relationship between them and achieved scores.

ResultsOur SCT was approved by an experts committee. It met reliability and accessibility criteria and it allowed distinguishing experts from paediatric internal residents. No statistically significant differences were found concerning age, gender, type and duration of the training received in Primary Care, and the completion of a course on that training.

ConclusionsWe developed an SCT that was approved by a Paediatric Experts Committee, it met reliability and accessibility criteria and it allowed distinguishing clinical reasoning from experts and paediatric internal residents. Except second year residency program, we did not objectified relevant differences in residency program year, age, gender, duration and realization of Paediatric Primary Care rotation, and training course realisation.

La formación especializada vía MIR (médico interno residente) apenas ha evolucionado en los últimos 30 años1 y es necesario revisarla para adaptarla a las novedades surgidas en el campo formativo y la evaluación.

En España, la formación del pediatra es mayoritariamente hospitalaria2, a pesar de que la organización sanitaria se basa en un modelo de Atención Primaria (AP). La Pediatría de Atención Primaria (PAP) tiene como objetivo fundamental la población infantil en todas sus etapas y por ello la rotación de los residentes en ella es imprescindible para su formación, independientemente del ámbito de su futura labor asistencial3.

No es hasta 2006 cuando el nuevo programa de la especialidad reguló la rotación específica y obligatoria en AP durante 3 meses3; sin embargo, desde diferentes sociedades pediátricas se ha solicitado que se alargue hasta completar 12 meses, pudiendo así contrarrestar la formación casi exclusiva hospitalaria4. Dicha petición debe ir asociada a una autoevaluación permanente del sistema MIR que permita detectar áreas susceptibles de mejora y adaptar dicha formación a la situación actual de la PAP1.

El proceso formativo de los profesionales médicos se basa en la adquisición de conocimiento teórico, habilidades profesionales y razonamiento clínico, siendo los dos últimos aspectos adquiridos durante el posgrado. Típicamente la evaluación del posgrado se ha basado exclusivamente en la evaluación mediante exámenes, como el test de elección múltiple, junto con la opinión subjetiva de los evaluadores5, evaluando la información fuera de contexto y sin representar adecuadamente la práctica clínica real.

Actualmente, nuevas metodologías como el script concordance test (SCT) evalúan adecuadamente de forma objetiva el razonamiento clínico, ya que proveen hipótesis a los sujetos evaluados y guían la recolección de información y la toma de decisiones, usando la información recogida para confirmar o rechazar dichas hipótesis5, de forma similar a la práctica clínica habitual.

Las características de este tipo de cuestionario se basan en una hipótesis que sugiere que el conocimiento estructurado está conformado por una compleja red de conexiones mentales que interrelacionan diferentes situaciones clínicas y permiten a los profesionales solventar problemas de su práctica clínica. Por ello, los profesionales más experimentados no serían aquellos que acumulan mayor cantidad de conocimientos, sino aquellos cuya red de interrelaciones mentales es más rica5.

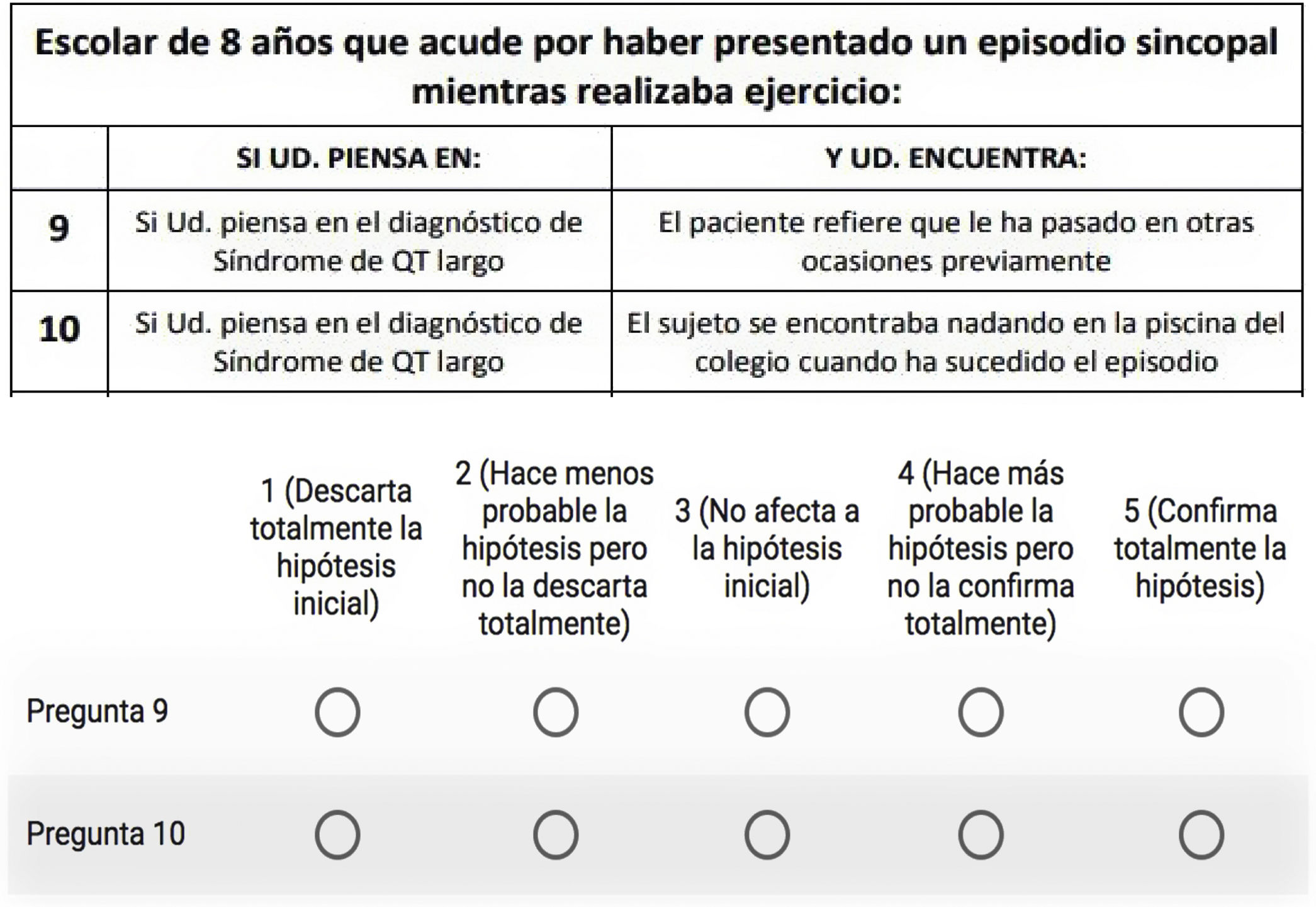

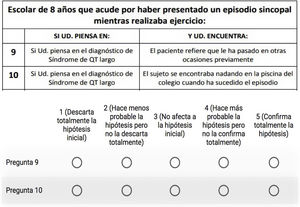

El SCT presenta un caso clínico (fig. 1), define las hipótesis que el profesional puede plantearse sobre los signos y síntomas que el paciente presentará, y finalmente proporciona una información añadida. Cuando el profesional recibe dicha información debe decidir cómo encaja con el caso clínico inicial y la hipótesis planteada posteriormente: confirmarla, rechazarla o no verse afectada por ella, en una escala Likert de 5 puntos5.

Ejemplo de un caso clínico en un SCT5.

Varios estudios con SCT muestran como la experiencia del profesional, medida exclusivamente como número de años de trabajo, no se asocia con un mejor razonamiento clínico si dicha experiencia no va asociada con un incremento en la práctica clínica que queremos evaluar (por ejemplo, número de cirugías practicadas, en el caso de Ginecología)6 o del reciclaje formativo en dicha disciplina (realización de cursos, en el caso de Cardiología Pediátrica)5. Esto indica que la experiencia del profesional reduciría el razonamiento clínico si no se acompaña de ambos elementos.

Además, existe evidencia sobre la pérdida de conocimiento a lo largo del tiempo, la llamada curva del olvido, una función que muestra una reducción logarítmica en la memoria de retención dependiendo del tiempo transcurrido7. Actualmente muchos programas formativos se centran en la importancia de luchar contra ella mejorando la retención a largo plazo mediante el reciclaje formativo de los profesionales8. Los conocimientos, como base del razonamiento clínico, si se encuentran en constante actualización, permiten luchar contra la curva del olvido, y así, de forma indirecta, influir positivamente en el razonamiento clínico de los profesionales.

Hasta ahora, el SCT se ha aplicado en diversas especialidades para evaluar el razonamiento clínico, sin embargo, son pocos los estudios en el ámbito pediátrico, y ninguno en España que incluya contenidos propios de PAP, a pesar de que en AP es donde se resuelve más del 90% de la patología pediátrica y es donde ejercen su labor profesional casi el 80% de los residentes que terminan su formación MIR2.

Por esta razón consideramos relevante diseñar un SCT de PAP que, como objetivos principales, cumpla los criterios de validez de contenido y criterio, fiabilidad y aceptabilidad descritos en la bibliografía. Nuestro estudio permitirá a su vez analizar:

- •

si los residentes tienen suficiencia razonamiento clínico en conocimientos de PAP para la práctica clínica;

- •

si el año de residencia dentro del programa MIR influye en la puntuación obtenida;

- •

si los años de experiencia en PAP de los expertos influyeron en la puntuación obtenida;

- •

si existe conexión entre la realización y longitud de la rotación en PAP y la puntuación obtenida;

- •

si el género y la edad de los residentes influyen en la puntuación obtenida;

- •

si la realización de un curso de PAP es suficiente para mejorar los resultados obtenidos.

El primer autor desarrolló un SCT de 115 preguntas, siguiendo las normas de construcción9 y utilizando motivos de consulta frecuentes de las consultas de PAP y bibliografía sobre la formación en PAP10.

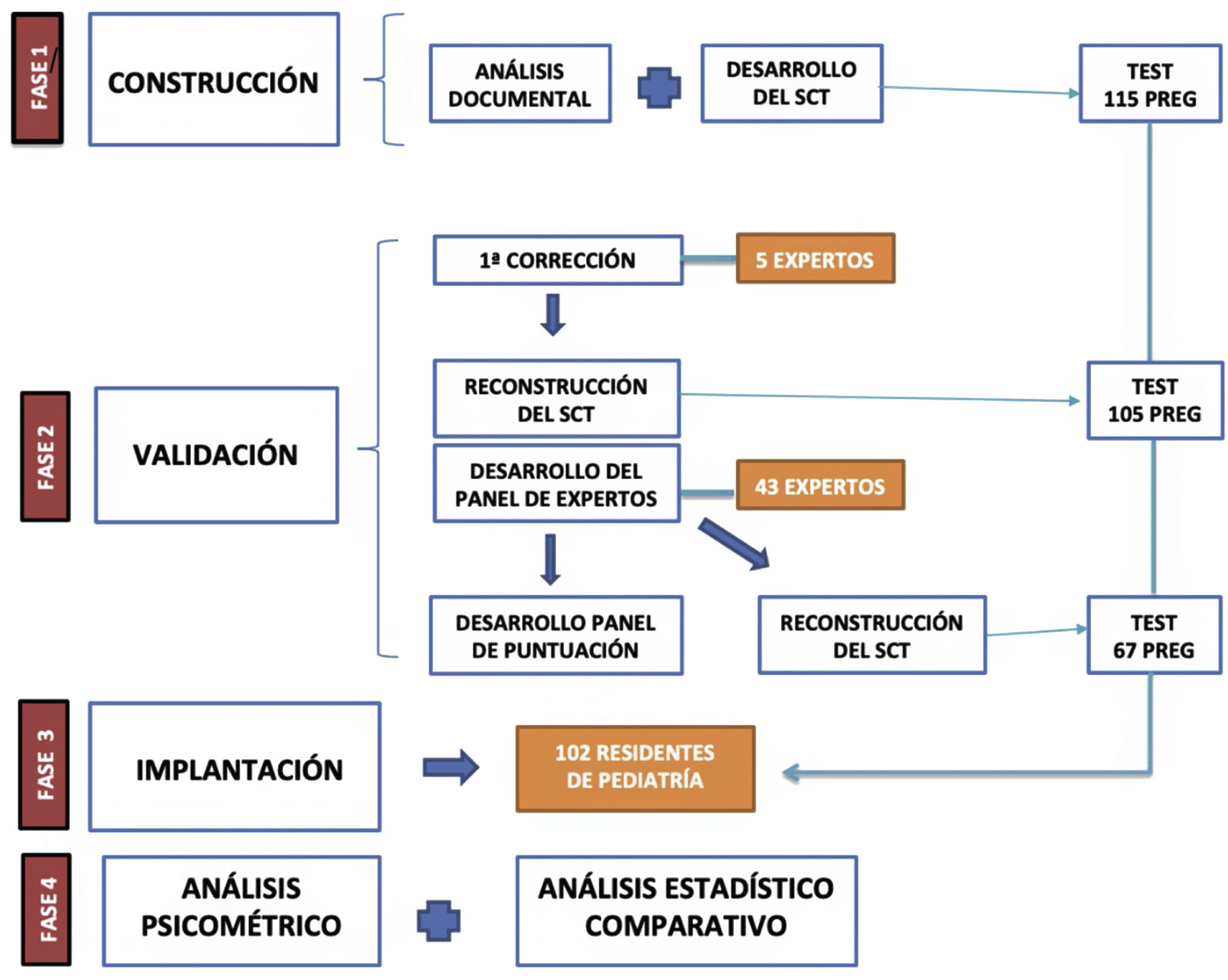

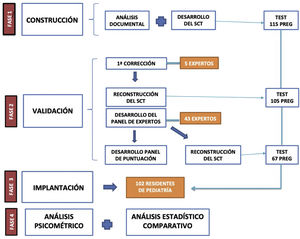

La validación del cuestionario, cuyo proceso es esquematizado en la figura 2, se inicia con la corrección por parte de 5 expertos en PAP (6 o más años de experiencia), que corrigieron las preguntas y seleccionaron aquellas que obtuvieron el 80% de aprobación por su parte (criterio de jueces11), reduciendo la extensión del cuestionario a 105 preguntas.

Para crear el panel de expertos, el test fue administrado on line con Google Form (disponible en https://www.google.es/intl/es/forms/about/) a diversas sociedades y foros pediátricos. Se recibieron 45 cuestionarios, superando así ampliamente las publicaciones pediátricas previas12,13.

Se recogieron además de estos el género, la edad y los años de experiencia laboral en PAP. El panel de puntuación fue creado con las respuestas del panel de expertos, eliminándose las preguntas no discriminativas (varianzas extremas, unanimidad en respuestas o respuestas repartidas homogéneamente), reduciéndose el cuestionario final a 67 preguntas.

Finalmente, el SCT definitivo fue remitido a 1.750 residentes de las unidades docentes de Pediatría de España, recogiéndose 102 cuestionarios (tasa de respuesta del 5,8%).

La superación del cuestionario se basó en el criterio de Duggan de clasificar a los sujetos en función de la puntuación obtenida, medida en desviaciones estándar (DE) respecto a la media obtenida por el panel de expertos, estableciendo las 4DE como punto de corte14.

En cada cuestionario se recogieron estas variables: año formativo MIR, edad, género, rotación o no en PAP, duración de dicha rotación (<1mes, 1-3meses, >3meses), y realización o no de un curso de contenidos de PAP.

La t de Student fue usada para la comparación de medias y el análisis de varianza de una vía (ANOVA) fue empleado para comparar más de 2 medias. La relación entre variables numéricas se estudió gráficamente y mediante regresión lineal. Todas las comparaciones estadísticas fueron llevadas a cabo usando un test bilateral con un nivel de significación de p=0,05, siendo todo procesado con Stata 14.2 software©.

Las propiedades psicométricas del cuestionario analizadas fueron validez, fiabilidad (mediante el alfa de Cronbach15) y aceptabilidad.

ResultadosRespecto a la validez, las 67 preguntas del cuestionario cumplieron con el criterio de jueces (superación del 80% de aprobación) y permitieron confirmar la hipótesis inicial del nivel formativo: los expertos obtendrían una puntuación superior a los residentes; y el cuestionario, por tanto, permitiría discriminar entre ambos.

En relación con la fiabilidad, el coeficiente de Cronbach obtuvo un valor de 0,74 para los residentes.

Cinco residentes (4,9%) no superaron el cuestionario según el criterio de Duggan (4DE). Dos expertos fueron eliminados del análisis por no superar el valor 50 en la puntuación (49,4 y 46,1).

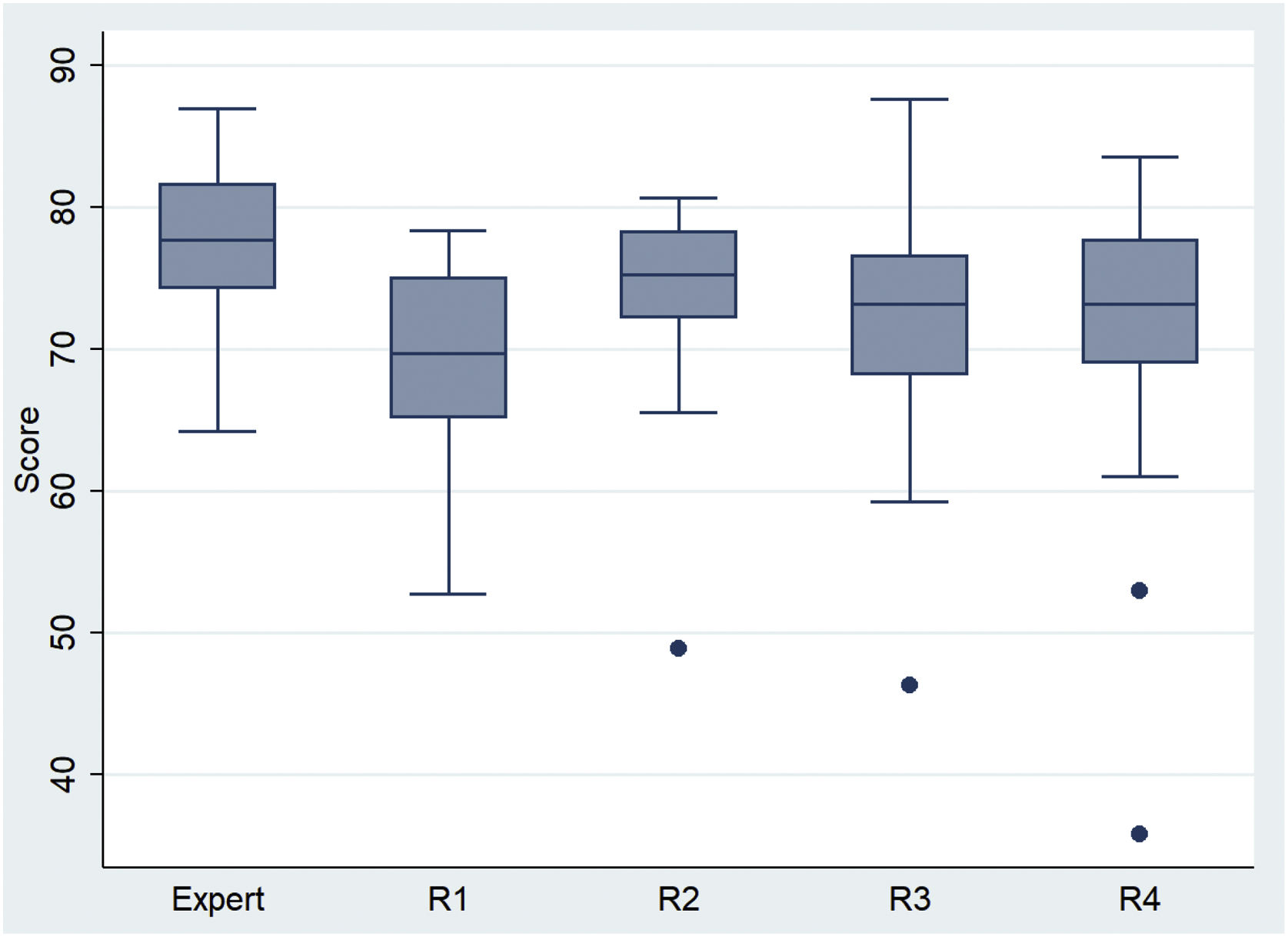

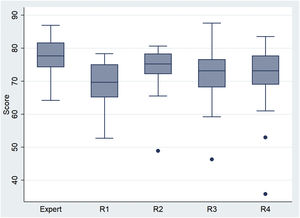

Los expertos (N=43) obtuvieron una puntuación media de 77,3 (DE=5,4), superior a la media 71,7 (DE=7,8) en los N=102 residentes (p<0,00005). Esta diferencia con los expertos se concretó para los R1 (p<0,00005), R3 (p<0,001) y R4 (p<0,011), pero no para los R2 (p=0,078). Los residentes R2 fueron los que obtuvieron la mayor puntuación media (tabla 1 y fig. 3), con 4,5 puntos por encima de los R1 (p=0,0287, IC95% [0,5; 8,5]). Las diferencias con R3 y R4 no resultaron estadísticamente significativas.

Medidas de tendencia central y dispersión de las puntuaciones obtenidas por los residentes

| N | Media | DE | |

|---|---|---|---|

| Año de residencia | |||

| R1 | 25 | 69,6 | 6,1 |

| R2 | 21 | 74,1 | 7,2 |

| R3 | 32 | 71,9 | 7,5 |

| R4 | 24 | 71,4 | 10 |

| Sexo | |||

| Hombre | 24 | 70,1 | 9,2 |

| Mujer | 78 | 72,1 | 7,3 |

| Rotación PAP | |||

| Sí | 78 | 72,4 | 8,1 |

| No | 24 | 69,3 | 6,3 |

| Duración de Rotación | |||

| 1 mes | 15 | 73,8 | 8,2 |

| 1-3 meses | 56 | 72,5 | 7 |

| >3 meses | 7 | 68,8 | 15 |

| Curso PAP | |||

| Sí | 55 | 71,7 | 9,5 |

| No | 47 | 71,7 | 5,4 |

DE: desviaciones estándar; PAP: Pediatría de Atención Primaria.

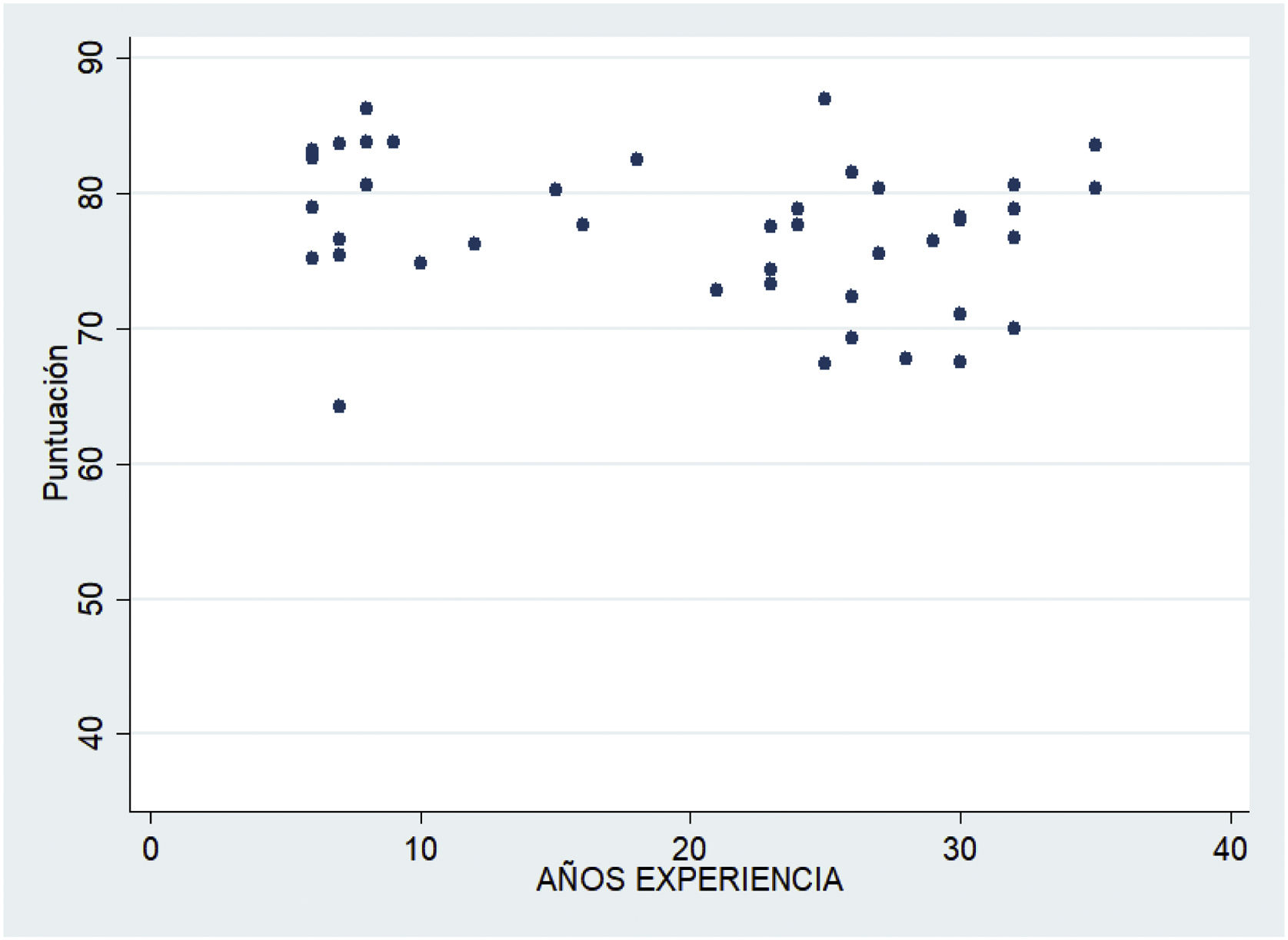

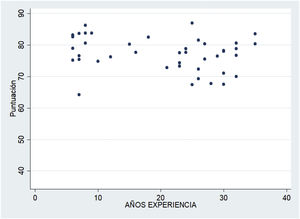

La figura 4 no evidencia relación entre los años de experiencia en PAP de los expertos y la puntuación obtenida (p=0,1).

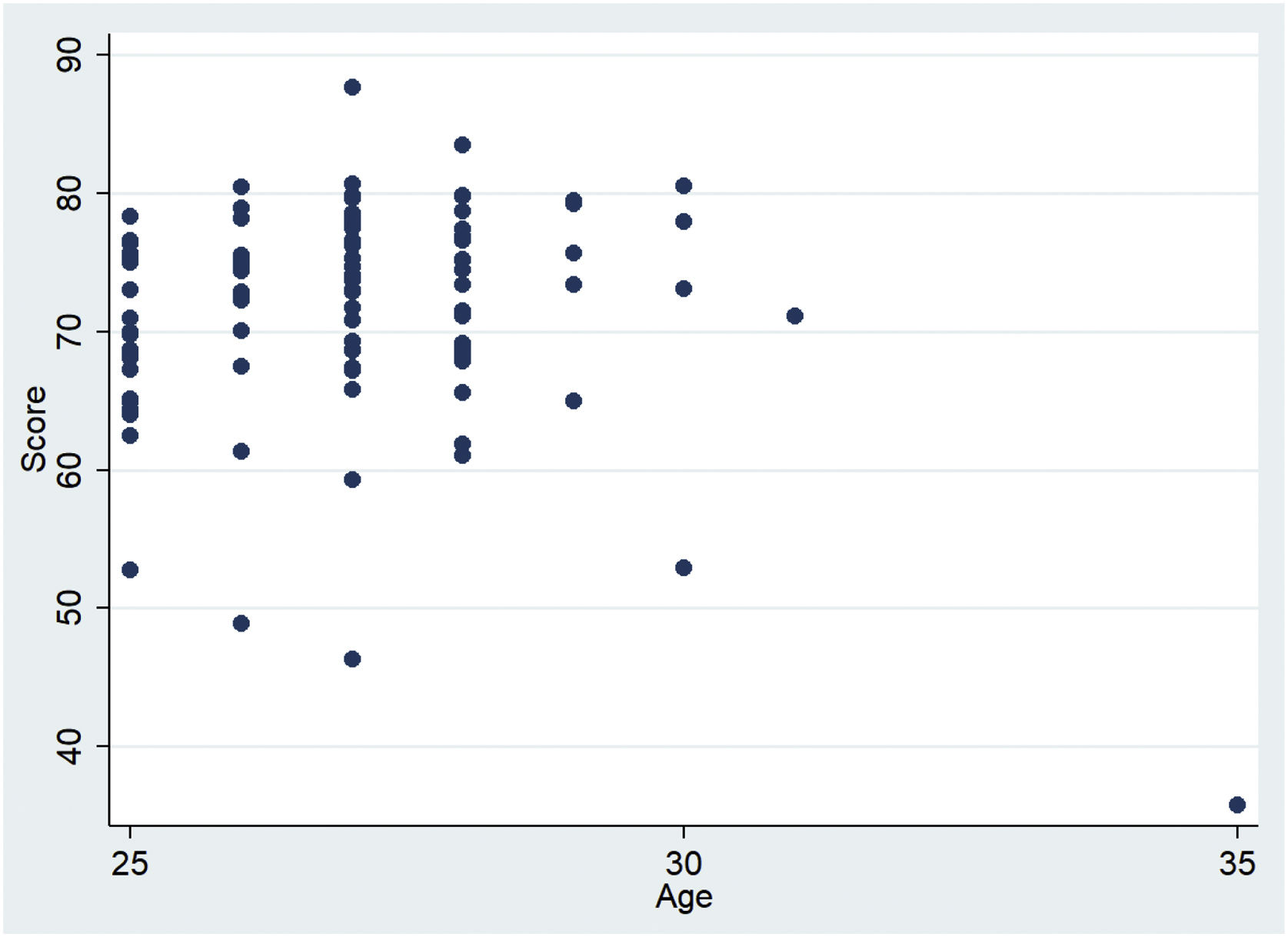

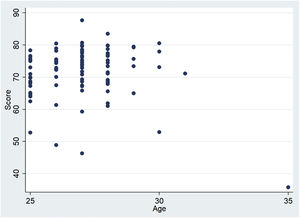

No se observaron diferencias estadísticamente significativas en la puntuación entre hombres y mujeres residentes (p=0,331). La relación entre la edad y la puntuación no resultó estadísticamente significativa (p=0,5753) (fig. 5).

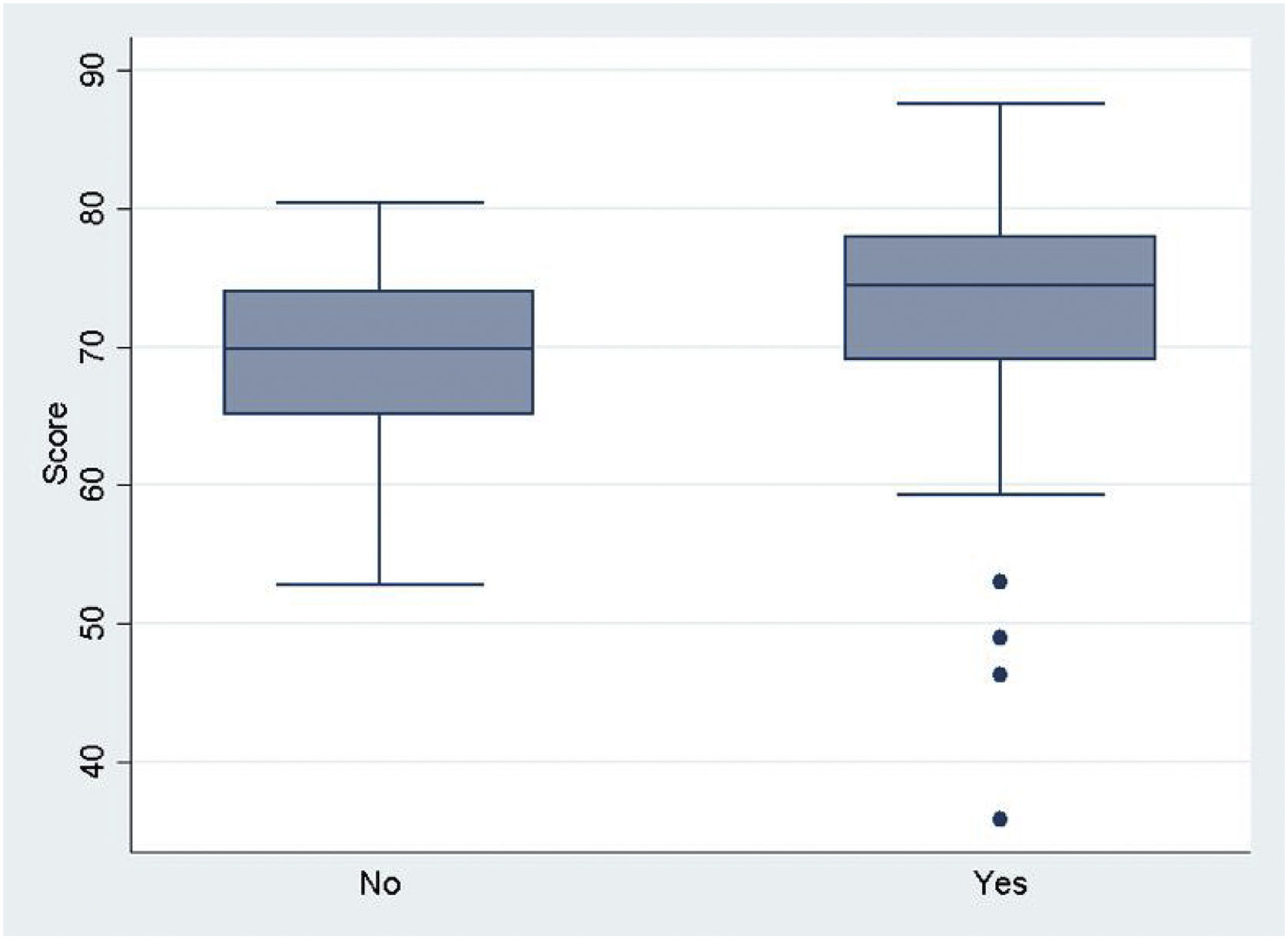

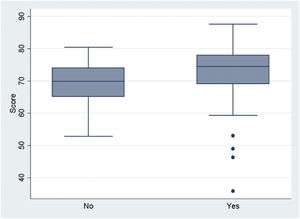

En relación con la rotación en PAP (fig. 6), no se obtuvieron diferencias significativas en las puntuaciones medias obtenidas a favor de aquellos sujetos que rotaron (p=0,058). Tampoco se obtuvieron diferencias significativas al comparar los 3 periodos de duración de la rotación en PAP (p=0,4089).

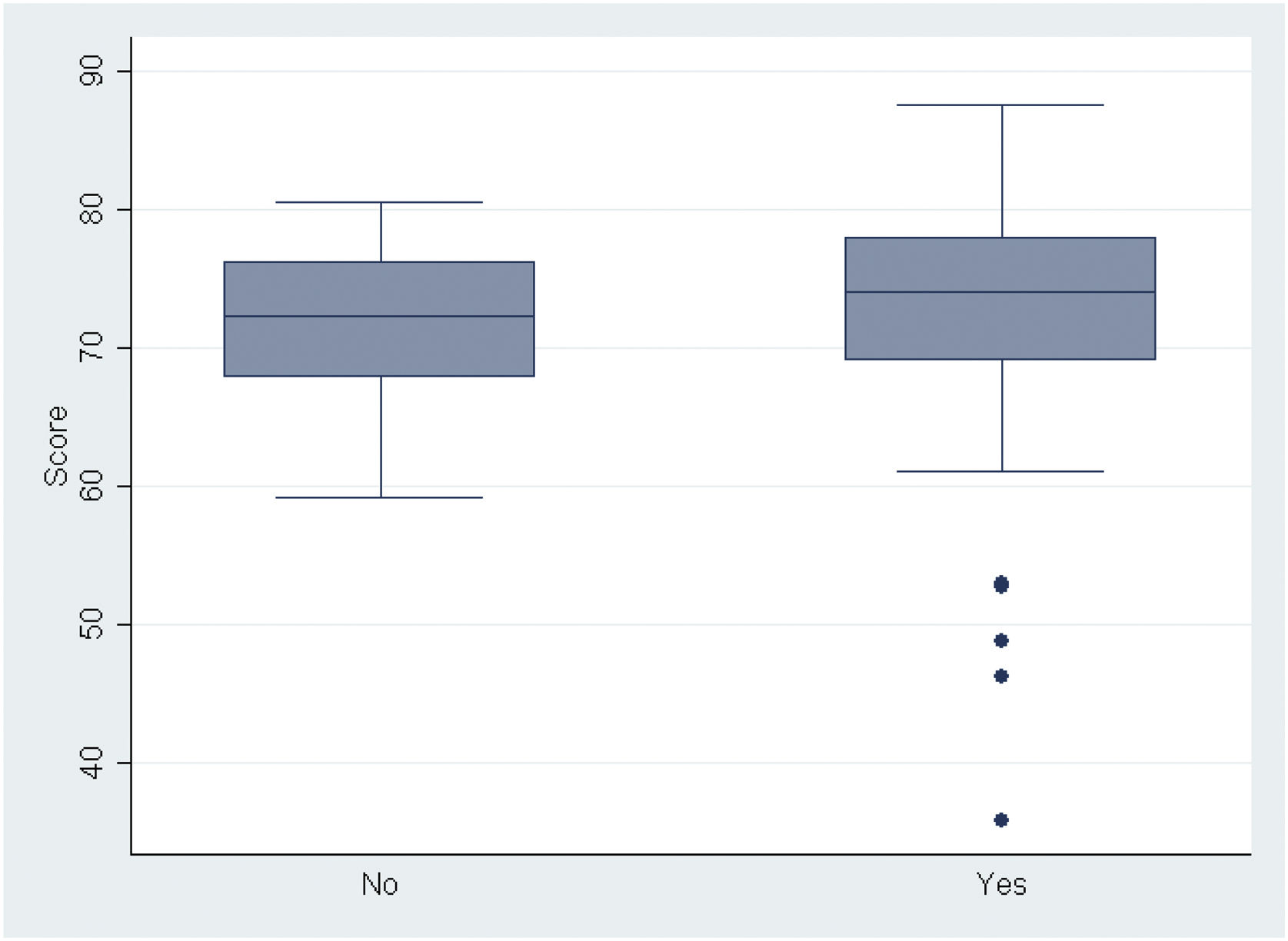

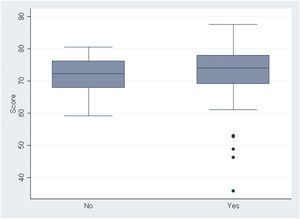

Respecto a la realización de un curso de PAP (fig. 7), al comparar la puntuación media obtenida por los residentes, no se obtuvieron diferencias significativas a favor de aquellos que habían completado un curso (p=0,995).

DiscusiónUn cuestionario SCT de 67 preguntas fue creado cumpliendo con los criterios de validez, ya que el razonamiento clínico fue mayor en los expertos respecto del conjunto de residentes como en los siguientes trabajos13,16–21.

Respecto a la fiabilidad, la consistencia interna calculada fue de 0,74 puntos, por lo cual resultó adecuada al superar el valor mínimo de 0,7 descrito en la bibliografía22.

Consideramos que se hubiera podido incrementar la fiabilidad incrementando la longitud del cuestionario, pero esto probablemente hubiera afectado negativamente al tamaño muestral. Pese a ello, nuestra muestra de 102 cuestionarios permitió alcanzar los objetivos de validez del cuestionario, y solamente ha sido superado por un trabajo con 268 cuestionarios, aunque todos del mismo año de residencia23.

La aceptabilidad (construcción, puntuación, corrección codificación e interpretación del cuestionario) fue acorde a lo descrito en la bibliografía.

El porcentaje de residentes que no superaron el cuestionario (4,9%) fue muy similar al descrito por Duggan (3%)14 y a la mayoría de estudios6,24–27, por lo que consideramos que el dintel utilizado para fijar el aprobado fue adecuado, y permitió detectar correctamente a aquellos sujetos con razonamiento clínico deficitario.

Como se esperaba, dependiendo del nivel formativo de los sujetos evaluados, las puntuaciones fueron más altas en el grupo de expertos respecto a los residentes. Estas diferencias coincidieron con multitud de trabajos publicados12–14,28–34, lo que confirmaría la correcta construcción del cuestionario.

Sin embargo, no se objetivó incremento de la puntuación obtenida según se avanzaba en el año formativo MIR. Este resultado coincidió con lo obtenido en los trabajos de Power et al.18 y Steinberg et al.35, donde tampoco se observó un aumento de la puntación según se ascendía en el año de residencia, y fue contrario a lo observado en dos trabajos donde se evaluó también a residentes de Pediatría12,13.

Si bien podría esperarse que los R4 hubieran obtenido la mayor puntuación, al ser los residentes, en teoría, mejor formados, lo cierto es que fueron los R2 los que obtuvieron la mayor puntuación.

La mayor puntuación obtenida por los R2 pensamos que podría explicarse por dos aspectos: el primero, el haber superado el primer año de residencia, punto de partida formativo; y el segundo, el hecho de que durante el primer año de residencia se llevan a cabo rotaciones donde se manejan conocimientos más relacionados con el razonamiento clínico en PAP, como los de las secciones de Urgencias o Neonatología.

La ausencia de diferencias significativas al comparar a los R2, R3 y R4 entre sí también fue observada en los trabajos de Power et al.18 y Steinberg et al.35 y apoyaría la idea de que esta herramienta no sería útil para discriminar a los residentes entre sí, sino para comparar a los adjuntos ya formados y a los residentes en formación.

Al contrario que lo observado en los trabajos de Rajapreyar et al.31 y Kazour et al.36, donde las puntuaciones disminuían según se incrementaba la experiencia del sujeto, o si este no se había reciclado formativamente5, en nuestro caso no se observó relación entre los años de experiencia en PAP de los expertos y la puntuación obtenida en el cuestionario.

Consideramos que, al ser una disciplina tan amplia, sería muy poco frecuente que el experto evaluado no hubiera realizado al menos un curso formativo sobre conocimientos de PAP durante su experiencia laboral. Sobre todo, si tenemos en cuenta que la muestra de expertos provenía de pediatras pertenecientes a varias sociedades y/o foros de pediatría, que promueven el reciclaje formativo. Esto podría suponer un sesgo de selección y así justificar que dicha puntuación no disminuyese con la edad, ya que estos sujetos podrían haber realizado más cursos, y, por tanto, encontrarse más sujetos reciclados desde el punto de vista formativo, aunque dicha variable no fuese recogida en este trabajo.

No se observaron diferencias en las puntuaciones obtenidas en función del género, presentando nuestra muestra, con un 76,4% de mujeres residentes, una distribución por género acorde con lo descrito en la bibliografía actual1.

En relación con la rotación en PAP, no se observaron diferencias estadísticamente significativas en las puntuaciones. Estos resultados coinciden con lo expuesto en el trabajo de Peyrony et al.37. Sin embargo, otros autores sí obtuvieron diferencias significativas en las puntuaciones tras haber rotado36,38,39.

Las comparaciones de la puntuación entre expertos y residentes, entre residentes, así como entre periodos de rotación en PAP, fueron también realizadas utilizando la prueba U de Mann-Whitney y la de Kruskal-Wallis, obteniendo las mismas conclusiones.

A la vista de estos trabajos consideramos que una variable que ha podido influir en nuestros resultados es la actual duración de 3 meses de la rotación en PAP, la cual podría resultar insuficiente para generar una mejora en el razonamiento clínico, precisando de una mayor duración, como reclaman los propios pediatras2 para mejorar los resultados obtenidos y obtener así diferencias significativas, lo que se apoyaría en otros trabajos5,36,38.

La ausencia de diferencias significativas a favor de aquellos sujetos que realizaron un curso de AP iría en contra de lo expuesto en varios trabajos del ámbito de la Medicina familiar, Pediatría o Farmacia5,40,41.

Pensamos que una de las hipótesis que podría explicar este hecho es que no se cuantificó el número de cursos de reciclaje realizados sino solamente si se había realizado alguno. Consideramos que este hecho ha podido dificultar el poder discriminar entre aquellos más reciclados formativamente y aquellos que no, y por ello el resultado obtenido.

La hipótesis de que es necesaria la realización de varios cursos para mejorar el razonamiento clínico, y con ello la puntuación obtenida en el cuestionario, reforzaría la importancia del reciclaje formativo, en contraposición a la suma de años de práctica pediátrica5,31,42 como se mencionó en la introducción. Además, el desarrollo de este reciclaje formativo, focalizado en los déficits formativos de los profesionales, garantizaría la calidad de la práctica asistencial y permitiría satisfacer las demandas de la población con mayor eficiencia. Aunque no muchos trabajos analizaron esta variable, sí se objetivó un importante incremento de las puntaciones obtenidas tras completar cursos formativos5,40,41.

Como limitaciones de nuestro estudio, observamos, por un lado, la imposibilidad de cubrir con el SCT todos los contenidos de nuestra especialidad, ya que la excesiva longitud del cuestionario hubiese limitado más el tamaño muestral. Pensamos también que la baja tasa de respuesta puede deberse al recelo de algunos residentes a responder a las preguntas por su falta de adecuado razonamiento clínico y que por eso rechazaron la participación, limitando así el tamaño muestral y pudiendo generar una muestra no homogénea, de modo que la fiabilidad, aun siendo adecuada, no haya sido superior. Consideramos que la realización del cuestionario de forma presencial, supervisada y con limitación temporal podría incrementar el tamaño muestral.

Por ello, concluimos que nuestro SCT podría ser una herramienta útil para la evaluación y reciclaje formativo de los residentes. Con la creación de esta prueba no pretendemos sustituir sino complementar la evaluación del residente, ayudando al tutor y a los responsables institucionales de la formación de los MIR a evaluar a los residentes de forma completa y objetiva, por lo que planteamos su incorporación por los gestores sanitarios en las diferentes fases del proceso formativo pediátrico para su evaluación.

Creemos que, si el SCT se realizara de forma presencial, supervisada y obligatoria como parte del proceso formativo del residente, con limitación temporal, y optimizando su contenido y longitud para incrementar el tamaño muestral y su consistencia interna, podría ayudar a mejorar considerablemente la asistencia pediátrica.

ConclusionesSe construyó un SCT con 67 preguntas que fue aprobado por un comité de expertos, distinguió según el grado formativo de los sujetos evaluados, cumplió con los criterios de fiabilidad y accesibilidad, permitió detectar si los profesionales evaluados disponían del adecuado razonamiento clínico en PAP y si existían diferencias en dicho razonamiento entre adjuntos y residentes.

Excepto en el 2.o año de residencia, no se observaron diferencias estadísticamente significativas respecto al año formativo dentro de la residencia, la edad, el género, la realización y duración de la rotación en AP y la realización de un curso sobre dicha formación.

Con el análisis de los parámetros recogidos podemos concluir que este SCT podría ser una herramienta útil para la evaluación del razonamiento clínico suficiente en conocimientos de PAP en residentes.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.